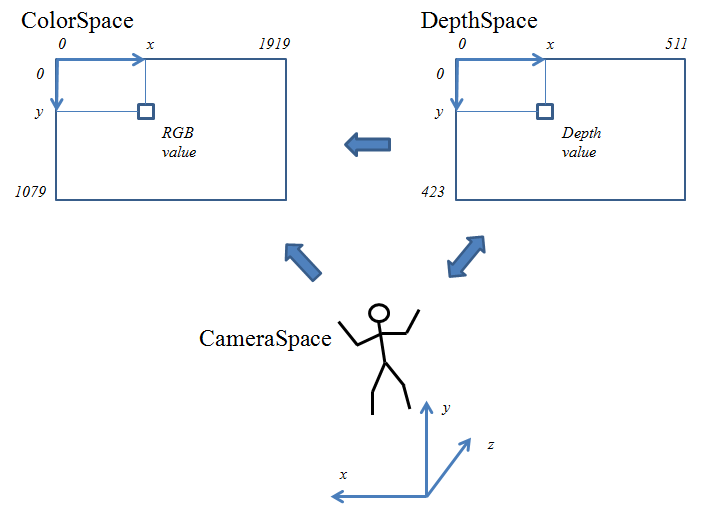

kinect.setSkeleton()メソッドを呼び出して骨格情報を kinect.skeleton に取得します。 関節の位置は CameraSpace 座標系で表現されているので、 ColorSpace 座標系の座標に変換してから RGB画像上に四角形を描画しています(緑字部分)。

Joint型のデータが意味を持つのは、その TrackingState メンバ変数の値が TrackingState_Tracked か TrackingState_Inferred である場合だけなので、 プログラム中では TrackingState_NotTracked である場合はその関節の表示処理をスキップしています。

| main.cpp |

#include <iostream> #include <sstream> #include "NtKinect.h" using namespace std; void doJob() { NtKinect kinect; while (1) { kinect.setRGB(); kinect.setSkeleton(); for (auto person : kinect.skeleton) { for (auto joint : person) { if (joint.TrackingState == TrackingState_NotTracked) continue; ColorSpacePoint cp; kinect.coordinateMapper->MapCameraPointToColorSpace(joint.Position,&cp); cv::rectangle(kinect.rgbImage, cv::Rect((int)cp.X-5, (int)cp.Y-5,10,10), cv::Scalar(0,0,255),2); } } cv::imshow("rgb", kinect.rgbImage); auto key = cv::waitKey(1); if (key == 'q') break; } cv::destroyAllWindows(); } int main(int argc, char** argv) { try { doJob(); } catch (exception &ex) { cout << ex.what() << endl; string s; cin >> s; } return 0; } |

RGB画像の上に、認識された関節が赤い四角形で示されます。OpenCVでは色をBGRの順番で表現するのが 普通なので cv::Scalar(0,0,255)は (青, 緑, 赤)=(0,0,255)、すなわち赤を表していることに注意しましょう。

上記のzipファイルには必ずしも最新の NtKinect.h が含まれていない場合があるので、 こちらから最新版をダウンロードして 差し替えてお使い下さい。