- プロパティを開きます

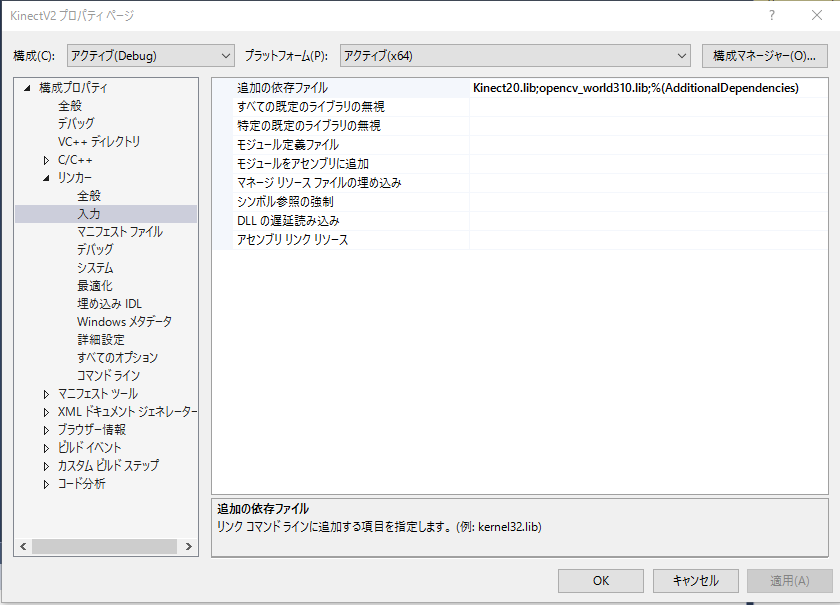

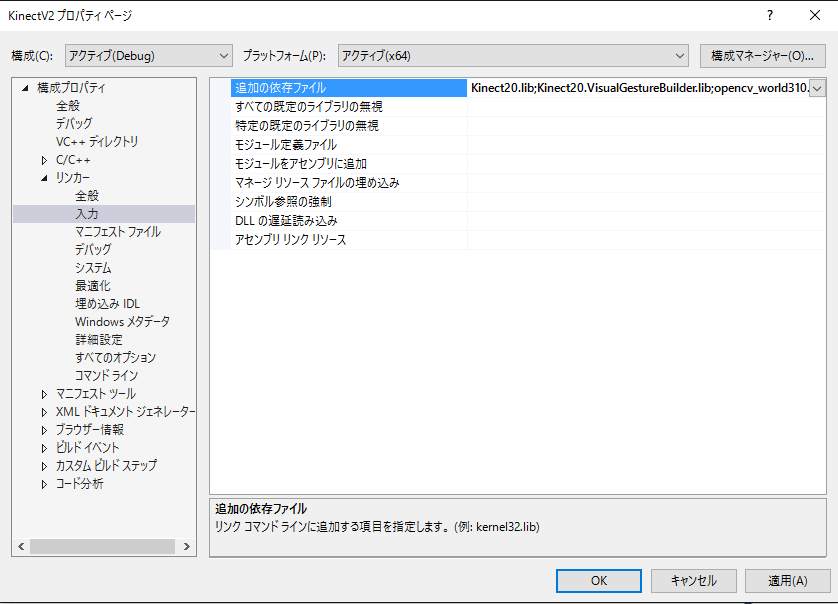

- Visual Gesture Builder 用のライブラリをリンクするように設定します。

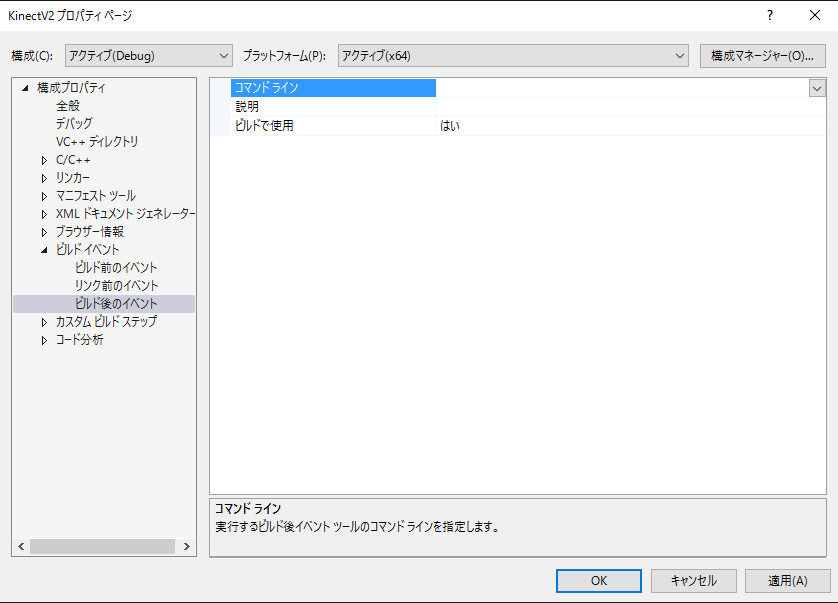

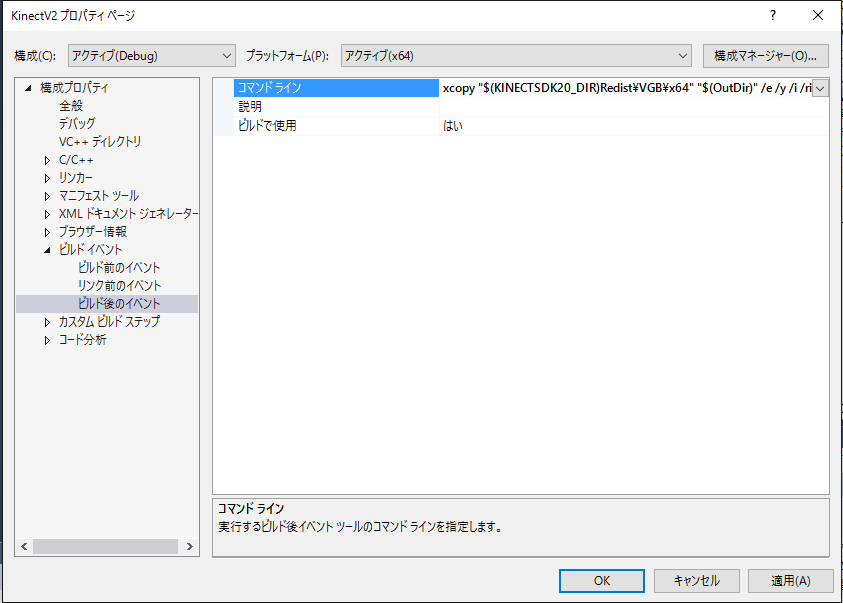

- Visual Gesture Builder関係の実行ファイルとジェスチャ定義ファイルが、プログラム実行時に適切な場所にコピーされるように設定します。

ソリューションエクスプローラ内のプロジェクト名(この例では KinectV2 )をクリックで選択してから、右ドラッグででプロパティを選択します。

Kinect20.VisualGestureBuilder.lib |

「構成プロパティ -> ビルドイベント -> ビルド後イベント -> コマンドライン」 で次の2行を追加する。

xcopy "$(KINECTSDK20_DIR)Redist\VGB\x64" "$(OutDir)" /e /y /i /r if exist "$(ProjectDir)\*.gbd" ( copy "$(ProjectDir)\*.gbd" "$(OutDir)" /y ) |

この例では、Kinect for Windows SDK v2.0 で配布されている以下の .gbd ファイルを用いています。

$(KINECTSDK20_DIR)Tools\KinectStudio\databases\SampleDatabase.gbd

まず最初に NtKinect 型の変数 kinect を宣言します。

kinect.setGestureFile(string)を呼び出して、検出すべきジェスチャの定義ファイルを設定します。

kinect.setSkeleton()メソッドを呼び出してから kinect.setGesture()メソッドを呼び出します。 ジェスチャが認識された場合は、kinect.discreteGesture や kinect.continuousGesture に設定されます。

| main.cpp |

#include <iostream> #include <sstream> #define USE_GESTURE #include "NtKinect.h" using namespace std; void putText(cv::Mat& img,string s,cv::Point p) { cv::putText(img, s, p, cv::FONT_HERSHEY_SIMPLEX, 1.0, cv::Scalar(0,0,255), 2.0, CV_AA); } void doJob() { NtKinect kinect; kinect.setGestureFile(L"SampleDatabase.gbd"); //kinect.setGestureFile(L"Seated.gbd"); while (1) { kinect.setRGB(); kinect.setSkeleton(); for (auto person: kinect.skeleton) { for (auto joint: person) { if (joint.TrackingState == TrackingState_NotTracked) continue; ColorSpacePoint cp; kinect.coordinateMapper->MapCameraPointToColorSpace(joint.Position,&cp); cv::rectangle(kinect.rgbImage, cv::Rect((int)cp.X-5, (int)cp.Y-5,10,10), cv::Scalar(0,0,255),2); } } kinect.setGesture(); for (int i=0; i<kinect.discreteGesture.size(); i++) { auto g = kinect.discreteGesture[i]; putText(kinect.rgbImage,kinect.gesture2string(g.first)+" "+to_string(g.second), cv::Point(50,30+30*i)); } for (int i=0; i<kinect.continuousGesture.size(); i++) { auto g = kinect.continuousGesture[i]; putText(kinect.rgbImage,kinect.gesture2string(g.first)+" "+to_string(g.second), cv::Point(500,30+30*i)); } cv::imshow("rgb", kinect.rgbImage); auto key = cv::waitKey(1); if (key == 'q') break; } cv::destroyAllWindows(); } int main(int argc, char** argv) { try { doJob(); } catch (exception &ex) { cout << ex.what() << endl; string s; cin >> s; } return 0; } |

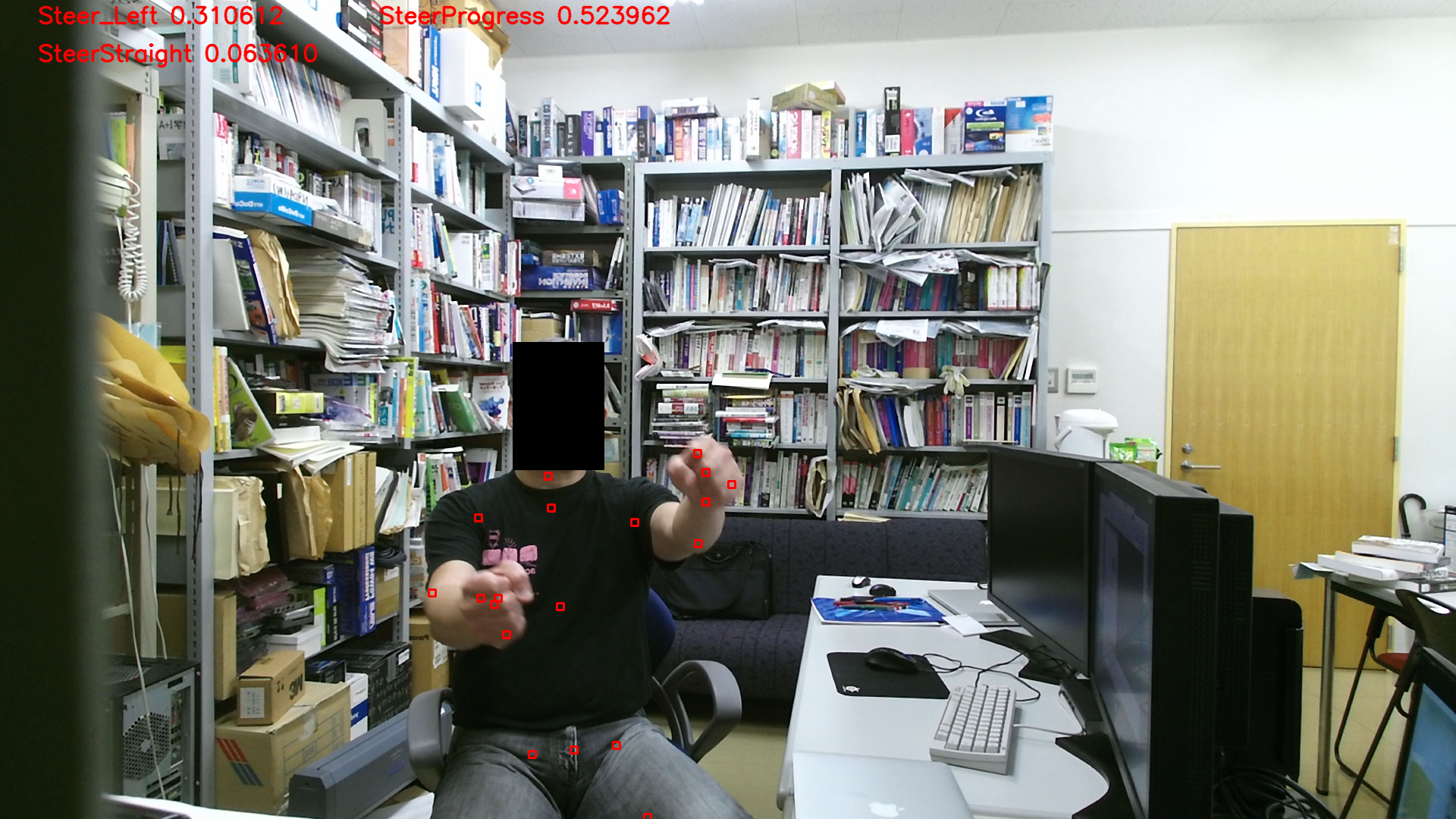

RGB画像の上方に、認識されたジェスチャが表示されます。 discrete ジェスチャは信頼度と共に左上に、continuous ジェスチャは進捗度と共にその右に表示されます。

上記のzipファイルには必ずしも最新の NtKinect.h が含まれていない場合があるので、 こちらから最新版をダウンロードして 差し替えてお使い下さい。

$(KINECTSDK20_DIR)bin\Database\Seated.gbd

まず Kinect Studio を用いて「所定のジェスチャを行っている場合と行っていない場合の両方を含む」動画を撮影します。

"Record"で記録する項目

o Nui Body Frame

x Nui Body Index <--いらないのでcheckをはずす

o Nui Depth

o Nui IR

o Nui Nui Sensor Telemetry

x Nui Title Audio <--いらないのでcheckをはずす

x Nui Uncompressed Color <--いらないのでcheckをはずす

次に、Visual Gesture Builder を用いて、動画からジェスチャ検出用ファイルを生成します。 ユーザが手動で、 動画のうち「左手を肩よりも上に上げる動作」をしている部分を positive 、 他の部分を negative な状態として定義し、Visual Gesture Builder に機械学習 させると結果として ジェスチャ検出用ファイル LeftHandUp.gba が生成されます。

ちなみに、このファイルの名前は "LeftHandUp.gbd" ではなく "LeftHandUp.gba"です。

本稿の Visual Studio のプロジェクトのジェスチャーの定義ファイルを、 今回生成した LeftHandUp.gba に差し替えて実行してみましょう。

kinect.setGestureFile(L"LeftHandUp.gba");

「左手だけを肩より上に上げる」動作をdiscrete gestureとして認識し

「右手だけを肩の上に上げる」動作や「両手を肩の上に上げる」動作は

認識しないことを確認して下さい。